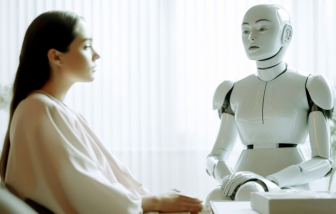

PNO - Các ứng dụng “bạn đồng hành trí tuệ nhân tạo (AI)” đang được hàng triệu người trên thế giới sử dụng. Tuy nhiên, các nhà nghiên cứu đã cảnh báo về nhiều nguy cơ từ mối quan hệ tưởng chừng vô hại này.

| Chia sẻ bài viết: |

Câu chuyện của người phụ nữ ở Giang Tô (Trung Quốc) đã thu hút 190 triệu lượt xem khi chia sẻ trên mạng xã hội.

6 trong số 10 thành phố ô nhiễm nhất thế giới nằm ở Ấn Độ, trong khi California có tình trạng ô nhiễm không khí tồi tệ nhất ở Bắc Mỹ.

Văn phòng Tổng thống Ukraine cho biết Kiev sẵn sàng chấp nhận đề xuất của Washington về việc thực hiện ngay một lệnh ngừng bắn tạm thời trong 30 ngày.

Khoảng 1/7 trẻ em và thanh thiếu niên từ 10-19 tuổi trên thế giới đang bị ảnh hưởng bởi các vấn đề về sức khỏe tâm thần.

Nhân viên tại sân bay quốc tế Newark Liberty (Mỹ) phát hiện 1 người đàn ông đang cố gắng lén mang 1 con rùa sống lên máy bay.

Các chiến binh ly khai đã tấn công và chiếm giữ 1 chuyến tàu ở tỉnh Balochistan, tây nam Pakistan, bắt hàng trăm người làm con tin.

Một số công đoàn lao động Trung Quốc đã ban hành thông báo chính thức tới các công ty, yêu cầu ngừng hỏi về tình trạng hôn nhân của lao động nữ.

Các bác sĩ cảnh báo hàng triệu phụ nữ có thể đang sống chung với tình trạng sức khỏe âm thầm khiến họ có nguy cơ đột quỵ và đau tim.

Mặc dù nổi tiếng là một đất nước an toàn nhất thế giới nhưng phần lớn người dân Nhật Bản lại cảm thấy xã hội ngày càng không an toàn.

Nghiên cứu mới cho thấy 'bộ não TikTok' do nghiện video ngắn trên mạng xã hội có ảnh hưởng đến tâm trạng, khả năng học tập và trí nhớ.

Sáng 11/3, cựu Tổng thống Philippines Rodrigo Duterte đã bị lực lượng chức năng nước này bắt giữ.

Hiệu quả “trị liệu tâm lý” thực sự như thế nào, các hệ lụy đằng sau đó là gì… là những vấn đề đang gây tranh cãi.

Chính quyền Guatemala đã sơ tán khoảng 1.000 người trong ngày 10/3, sau khi ngọn núi lửa hoạt động mạnh nhất Trung Mỹ phun trào, phun ra dung nham, tro bụi.

Nhà chức trách cho biết, ít nhất 11 người đã thiệt mạng và 12 người bị thương sau khi chiếc xe buýt bị lật ở bang Oaxaca, miền nam Mexico.

Xung đột sắc tộc, tôn giáo, cùng với dịch bệnh khiến Cộng hòa Dân chủ Congo trở thành một trong những nơi nguy hiểm nhất trên thế giới đối với phụ nữ.

Ngày 10/3, một cuộc khảo sát ở Hàn Quốc cho thấy, 6/10 nhân viên văn phòng tin rằng hôn nhân không còn cần thiết nữa.

Ngôi làng hẻo lánh và kém phát triển ở Trung Quốc là quê hương của nhà sáng lập Deepseek đã trở thành địa điểm du lịch nổi tiếng.

Hiện nay, cuộc khủng hoảng sức khỏe tâm thần đang gia tăng ở thanh thiếu niên trên thế giới đã làm đảo lộn mô hình hạnh phúc truyền thống.